歡迎閱讀我們的文章,今天我們將探討一個在網站開發中不可或缺的關鍵 – 「robot.txt」文件。在追求最佳搜索引擎優化(SEO)策略的過程中,你可能已經聽過這個詞。在引入這個具有神祕色彩的名詞之前,讓我們先搞清楚什麼是「robot.txt」文件。無論你是一個有經驗的開發者還是隻是對網站開發有基本瞭解的初學者,這篇文章將為你提供有價值的知識,幫助你取得更好的網站表現。現在,讓我們一起來探索這個網站開發中的關鍵元素吧!

「robot.txt」的基本結構與規則解析

在網站開發中,「robot.txt」文件是一個不可或缺的元素,它在SEO優化中扮演著重要的角色。該文件位於網站的根目錄下,並告訴搜索引擎的爬蟲(web crawler)哪些頁面可以被訪問和索引,以及哪些頁面應該被排除。透過「robot.txt」文件,開發者可以適當地控制爬蟲的行為,以確保網站的內容能夠被有效地運營。

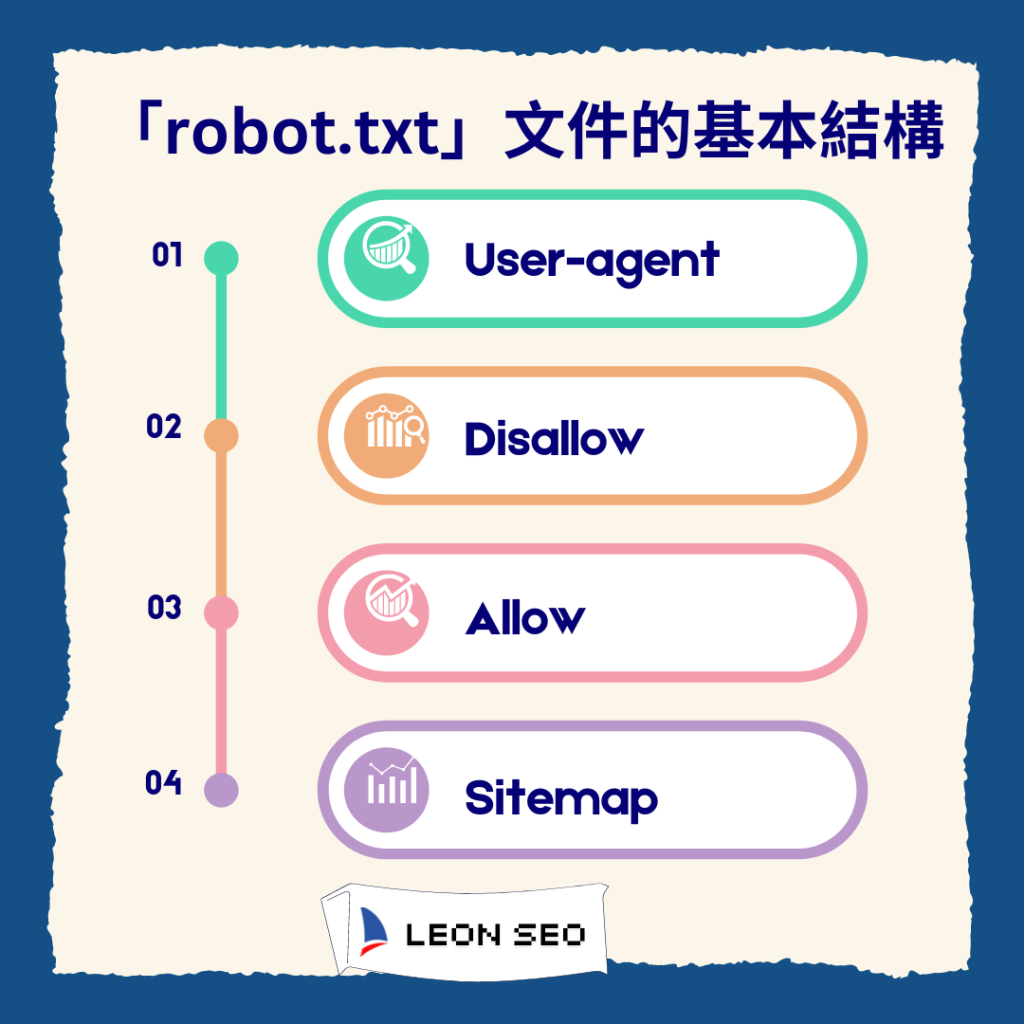

「robots.txt」文件的基本結構

讓我們來仔細解析「robot.txt」文件的基本結構和規則。首先,該文件是一個純文本文件,擁有獨特的命名方式,即「robots.txt」。它包含一系列的指令,每條指令佔據一行。每行指令分為兩個部分:「User-agent」和「Disallow」。其中,「User-agent」指定了受該指令影響的爬蟲,而「Disallow」則是指定了該爬蟲不被允許訪問的URL。

範例:阻止爬蟲訪問網站特定目錄

舉個例子來說,假設我們有一個名為「example.com」的網站,且我們希望阻止所有爬蟲訪問網站的「/private」目錄。我們可以在「robot.txt」文件中添加以下指令:

User-agent: *

Disallow: /private

這將告訴所有爬蟲不要訪問「example.com/private」目錄下的任何頁面。當然,這只是其中一個簡單的例子,「robot.txt」文件還可以根據特定的需求進行更複雜的配置。

其他常見的指令

除了「User-agent」和「Disallow」之外,「robot.txt」文件還可以使用其他指令,例如「Allow」、「Crawl-delay」等等,以實現更細緻的控制和定製。使用這些指令可以在爬蟲訪問網站時提供更詳細的指導,以達到更優化的效果。

總結來說,「robot.txt」文件是網站開發中一個關鍵的元素。透過適當的配置,開發者可以控制爬蟲的行為,確保網站的內容得到有效地管理和遞送。在接下來的文章中,我們將更深入地探討「robot.txt」文件的其他用途和相關策略,以幫助您更好地優化網站。

「robot.txt」文件與網站索引管理

在進一步探討「robot.txt」文件的重要性之前,我們需要先了解它與網站索引管理的關聯。簡單來說,「robot.txt」文件可以用來指示搜尋引擎爬蟲在訪問你的網站時應該遵守的規則。透過這個文件,你可以告訴爬蟲哪部分內容可以被索引,哪部份應該被排除。

這對於網站的索引管理至關重要。想像一下,如果你的網站有一些不想被搜尋引擎索引的頁面,或者你想要限制爬蟲訪問某些區域,「robot.txt」文件就派上了用場。它可以有效地控制爬蟲的訪問範圍,讓你能夠更好地管理和保護你的網站內容。

讓我們來看看「robot.txt」文件的基本結構,以及一些常見的規則:

- User-agent: 這個指令用來指定要對應的爬蟲名稱,例如Googlebot、Bingbot等。

- Disallow: 透過這個指令,你可以指定不希望搜尋引擎索引的頁面或目錄。例如,「Disallow: /admin」表示不允許任何爬蟲訪問/admin目錄下的內容。

- Allow: 相對於Disallow,這個指令則用來指定例外的規則。換句話說,你可以告訴爬蟲哪些頁面或目錄可以被索引。

- Sitemap: 如果你有提供網站地圖(sitemap.xml),你可以在「robot.txt」文件中使用這個指令將其指定出來。這樣一來,爬蟲訪問「robot.txt」文件時就可以找到你的網站地圖。

請注意,「robot.txt」文件並不是強制性的,而是一種建議和指示爬蟲的方式。有些爬蟲可能不會遵守這些規則,或者被惡意使用。因此,在某些情況下,「robot.txt」文件無法完全阻止某些內容被索引或訪問。儘管如此,大多數遵守遵守標準的爬蟲還是會尊重這些規則。

在下一段中,我們將探討「robot.txt」對爬蟲訪問控制的重要性,以及如何利用它來最佳化搜尋效能。

「robot.txt」對爬蟲訪問控制的重要性

「robot.txt」文件在網站開發和搜索引擎優化中扮演著重要的角色。它提供了一種方式,讓網站擁有者控制搜索引擎爬蟲(也稱為網絡機器人)對網站的訪問和索引。透過合理使用「robot.txt」文件,您可以精確指示爬蟲哪些頁面應該被訪問,那些頁面不應該被訪問。

首先,讓我們來看一下「robot.txt」文件的基本結構。它通常位於網站的根目錄下,並且命名為「robots.txt」。當搜索引擎的爬蟲訪問一個網站時,它會優先查找並讀取這個文件。所以它非常容易被執行並且可以迅速影響到您網站的索引情況。

「robot.txt」文件通過使用特定的語法和規則,告訴爬蟲哪些頁面是可以被訪問的,哪些頁面是不應該被訪問的。下面是一個簡單的規則示例:

| 語法 | 意義 |

|---|---|

| User-agent: * | 這行表示所有的爬蟲代理都適用以下的規則 |

| Disallow: /admin | 這行表示不允許爬蟲訪問「/admin」文件夾下的內容 |

| Allow: /images | 這行表示允許爬蟲訪問「/images」文件夾下的內容 |

通過合理設置這些規則,您可以控制爬蟲訪問您網站的頁面,從而達到更好的索引控制。可能您希望一些私密的內容,例如內部系統頁面或敏感數據頁面,不能被搜索引擎索引。使用「robot.txt」文件,您可以將這些頁面排除在搜索引擎的索引範圍之外,以保護您的資料安全。

此外,「robot.txt」文件還可以告訴爬蟲對您網站的訪問速度限制。例如,您可以設置「Crawl-delay: 5」,表示每個爬蟲在訪問一個頁面後需要等待5秒才能再次訪問。這樣可以避免過度訪問造成的負擔,同時提高網站的性能。

總結來說,「robot.txt」文件在網站開發中扮演著不可或缺的角色。通過使用這個文件,您可以控制搜索引擎爬蟲對網站的訪問和索引,保護私密頁面,調整爬蟲的訪問速度,從而達到更好的搜索引擎優化效果。

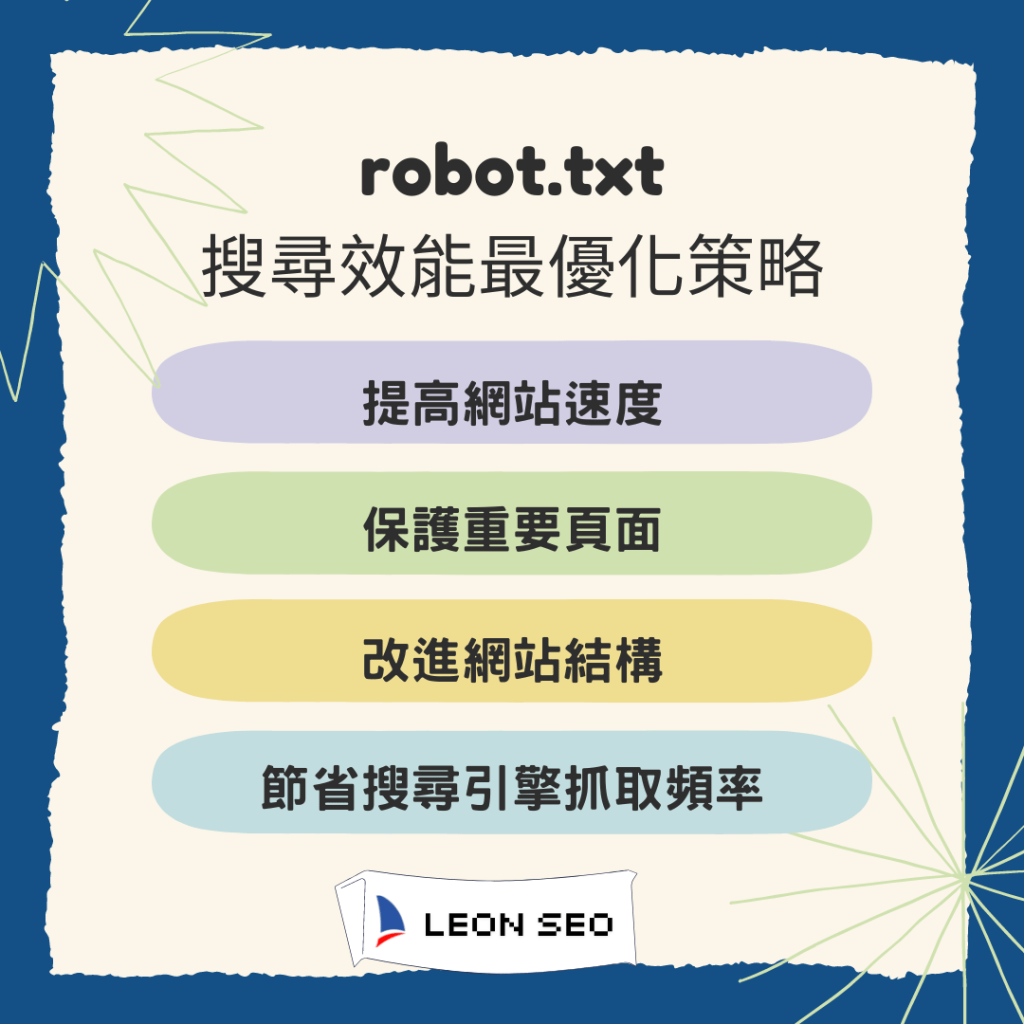

「robot.txt」與搜尋效能最優化策略

在網站開發和SEO優化的過程中,「robot.txt」文件扮演著至關重要的角色。它不僅可以控制搜尋引擎的爬蟲訪問,還可以幫助網站實現更佳的搜尋效能。讓我們來探討一下「robot.txt」如何與搜尋效能最優化策略相關連。

1. 提高網站速度

「robots.txt」文件可以用於阻止搜索引擎抓取不必要的資源和頁面,從而減少搜尋引擎的負載,提高網站的速度。速度是搜尋引擎排名算法的重要指標之一,優化網站的速度可以提高搜尋引擎的評價。

2. 保護重要頁面

通過「robots.txt」文件,您可以指定哪些頁面應該被搜索引擎索引,哪些頁面應該被排除在外。這將幫助您保護重要頁面,使其在搜索結果中得到更好的展示,同時避免無用頁面佔據搜索引擎的資源。

3. 改進網站結構

「robots.txt」文件可以讓您指定網站中的特定目錄和頁面是否應該被搜索引擎訪問。這使得您能夠更好地組織網站結構,使搜索引擎更容易抓取和理解您的網站內容。這對於建立良好的用戶體驗和提高網站的可見性至關重要。

4. 節省搜尋引擎抓取頻率

通過「robots.txt」文件,您可以限制搜索引擎的訪問頻率,避免不必要的爬蟲訪問,從而節省搜尋引擎的資源。這對於大型網站或擁有海量頁面的網站特別重要,可以避免被搜索引擎懲罰或降低訪問優先級。

總結起來,「robot.txt」文件與搜尋效能最優化策略密不可分。通過適當配置「robot.txt」文件,您可以改善網站的搜尋效能,提高網站的可見性和用戶體驗,同時節省搜尋引擎的資源。因此,在進行網站開發和SEO優化時,不要忽視「robot.txt」文件的重要性,它能夠為您的網站帶來巨大的益處。

「robot.txt」在多語言網站架構中的運用

在建立多語言網站時,「robot.txt」文件是一個非常重要的元素。這個文件可以幫助網站管理員控制搜索引擎爬蟲在不同語言版本網頁上的訪問和索引情況。為了確保搜索引擎可以正確地訪問和索引你的網站的各個語言版本,你可以使用「robot.txt」文件來指示搜索引擎爬蟲如何處理這些版本。這樣一來,你可以避免搜索引擎混淆不同語言版本的內容,並確保每個版本都能獨立地被搜尋引擎評估和顯示。

1. 確保列出每個語言版本的網頁

首先,你需要確保你的「robots.txt」文件中列出了每個語言版本的網頁。例如,如果你有一個英文和一個中文版本的網站,你應該在文件中指示搜索引擎爬蟲訪問這兩個版本的網頁。這樣搜索引擎就知道有哪些語言版本的網頁可以被索引。

2. 控制搜索引擎爬蟲行為

其次,你可以使用「robots.txt」文件中的指令來控制搜索引擎爬蟲在訪問和索引網頁時的行為。例如,你可以使用「Disallow」指令來阻止爬蟲訪問某些特定的網頁或資料夾,以控制搜索引擎的索引範圍。

3. 多語言網站的索引路徑

對於多語言網站,一個常見的做法是在「robots.txt」文件中為每個語言版本的網頁指定不同的索引路徑。這樣做可以確保不同語言版本的網頁在搜索引擎的索引結果中被正確地歸類和顯示。

例如,如果你的英文網頁路徑是「/en/」,中文網頁路徑是「/zh/」,你可以在「robot.txt」文件中使用以下指令:

User-agent: *

Disallow: /zh/

這樣一來,搜索引擎爬蟲將不會訪問和索引中文版本的網頁,只會訪問和索引英文版本的網頁。這樣可以確保搜索引擎在搜索結果中只顯示適合的語言版本,提高用戶體驗和網站的SEO優化效果。

4. 設定網頁優先級與爬蟲頻率

另外,你也可以使用「robots.txt」文件來定義不同語言版本的網頁的優先級。這可以影響搜索引擎爬蟲對你的網站的訪問頻率和索引更新頻率。例如,你可以使用以下指令:

User-agent: *

Disallow: /zh/

總結而言,「robots.txt」文件在多語言網站的開發中起著關鍵作用。它可以幫助你管理不同語言版本的網頁的訪問和索引情況,提高搜索引擎對你的網站的理解和評估。合理運用「robots.txt」文件,你可以更好地優化你的網站,提升SEO效果並提供更好的用戶體驗。

robot.txt結論

在網站開發中,「robot.txt」文件是一項不可或缺的關鍵,尤其在SEO優化方面更加重要。我們在本文中探討了「robot.txt」的基本結構與規則解析,以及它與網站索引管理的相關性。

通過適當地編寫「robot.txt」文件,我們可以對搜索引擎爬蟲的訪問進行控制,確保我們的網站僅顯示最有價值的內容,同時排除一些無關或不必要的頁面。這對於提高網站的搜索效能和用戶體驗至關重要。

此外,「robot.txt」文件也為我們提供了最佳的搜尋效能最優化策略。通過在文件中設置特定的指令,我們可以確保搜索引擎優先擷取最重要的頁面,同時避免重複或冗餘的內容被索引。

對於多語言網站,「robot.txt」文件的運用也是至關重要的。我們可以通過在文件中設置不同的語言版本的頁面路徑,以確保不同語言的用戶能夠獲得適切的內容,同時避免搜索引擎將不同語言版本的頁面視為重複內容。

總結來說,「robot.txt」文件在網站開發中扮演著重要的角色。它不僅可以控制搜索引擎爬蟲的訪問,提高網站的搜索效能和用戶體驗,還可以在多語言網站中發揮重要作用。因此,應該給予「robot.txt」的編寫和優化足夠的重視,以確保網站能夠取得更好的成果。

謝謝您的閱讀,希望本文能為您深入瞭解「robot.txt」文件帶來幫助。如果您對網站開發和SEO優化有更多的疑問,請隨時與我們聯繫,我們將竭誠為您提供支持和協助。

robot.txt常見問題QA

Q: 什麼是「robot.txt」文件?

「robot.txt」文件是一個位於網站根目錄下的文本文件,用於指導網絡爬蟲程序在訪問網站時的行為。它允許網站管理員指定哪些頁面或資源應該被爬取、哪些不應該被爬取。透過設置「robot.txt」文件,網站管理員可以向搜索引擎和其他爬蟲程序提供有關網站的重要信息。

Q: 如何編寫「robot.txt」文件?

編寫「robot.txt」文件可以通過在你的網站根目錄下新增一個名為「robot.txt」的文本文件來進行。在文件中,你可以使用一系列的指令和規則,以告訴爬蟲程序應該如何訪問和爬取你的網站。遵循這些指令和規則可以幫助控制搜尋引擎的訪問行為,從而更好地優化你的網站的SEO效果。

Q: 「robot.txt」文件有哪些常見的使用場景?

「robot.txt」文件在網站開發中具有多種常見的使用場景。首先,它可以用於管理網站的索引,通過指示搜索引擎不要爬取特定頁面或資源,幫助提高網站的搜尋排名。其次,它還可以用於控制爬蟲程序的訪問頻率,以避免對網站產生過多的流量和負擔。此外,「robot.txt」文件還可以在多語言網站架構中確保正確的內容被索引,並且適用於各種不同的網站平臺和內容管理系統。

以上是關於「robot.txt」文件的一些常見問題及其解答。希望這些資訊能夠幫助你理解並運用「robot.txt」文件在網站開發和SEO優化中的重要性。如果你還有其他疑問,請隨時聯繫我